GPT画像学習実験

🐠結論:利用できない

影響があったとしても画像出力に1~5%の影響

🐰やったこと:

プロジェクトを三つ用意し、それぞれに自分で描いた画像を20枚アップロードする。

一つのチャットスレッドを、それら3つのプロジェクトを移動させつつ画像を20枚づつ、計60枚を学習させた

また、既に俺の絵の学習をさせた状態で始めた

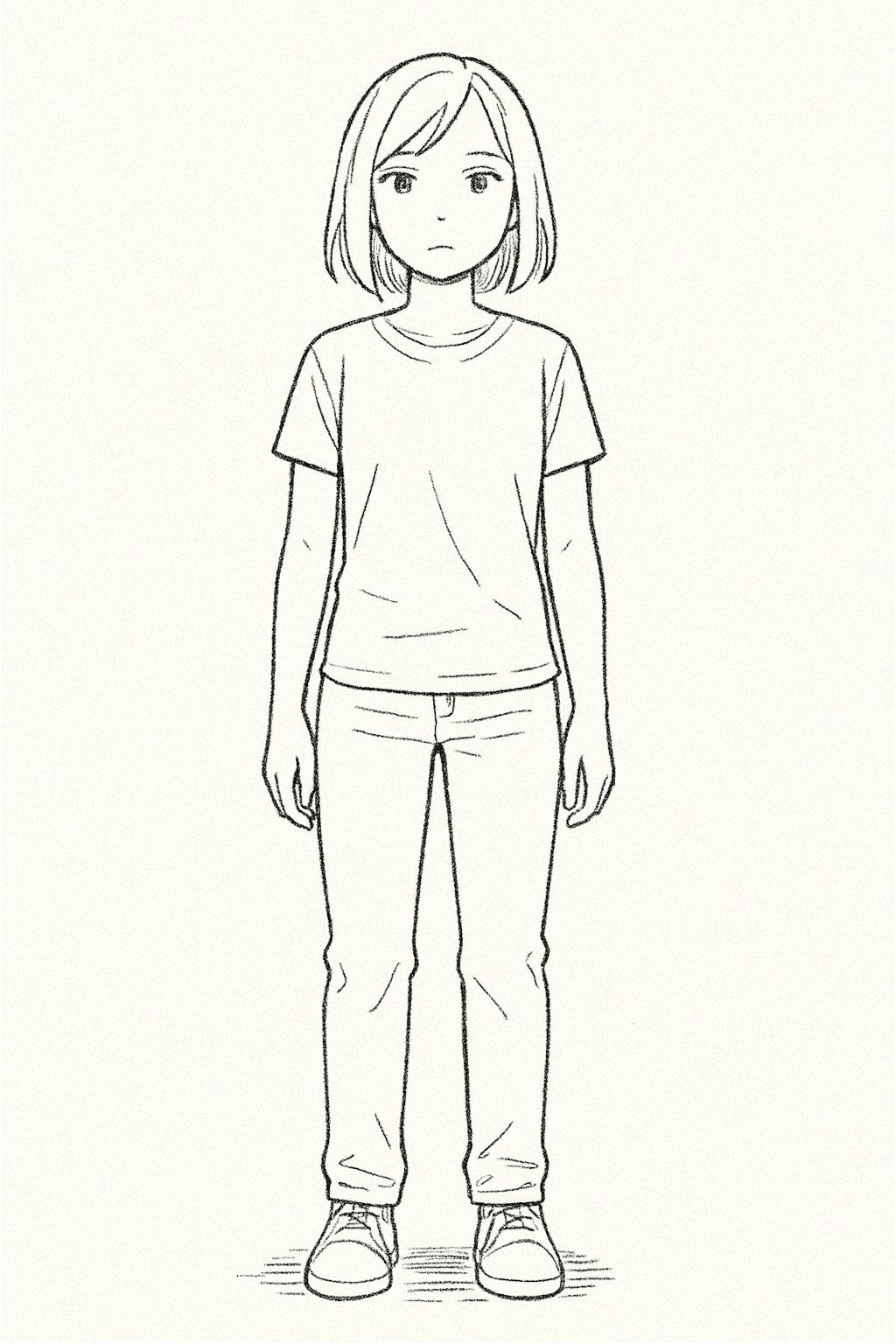

画像は左から順に、

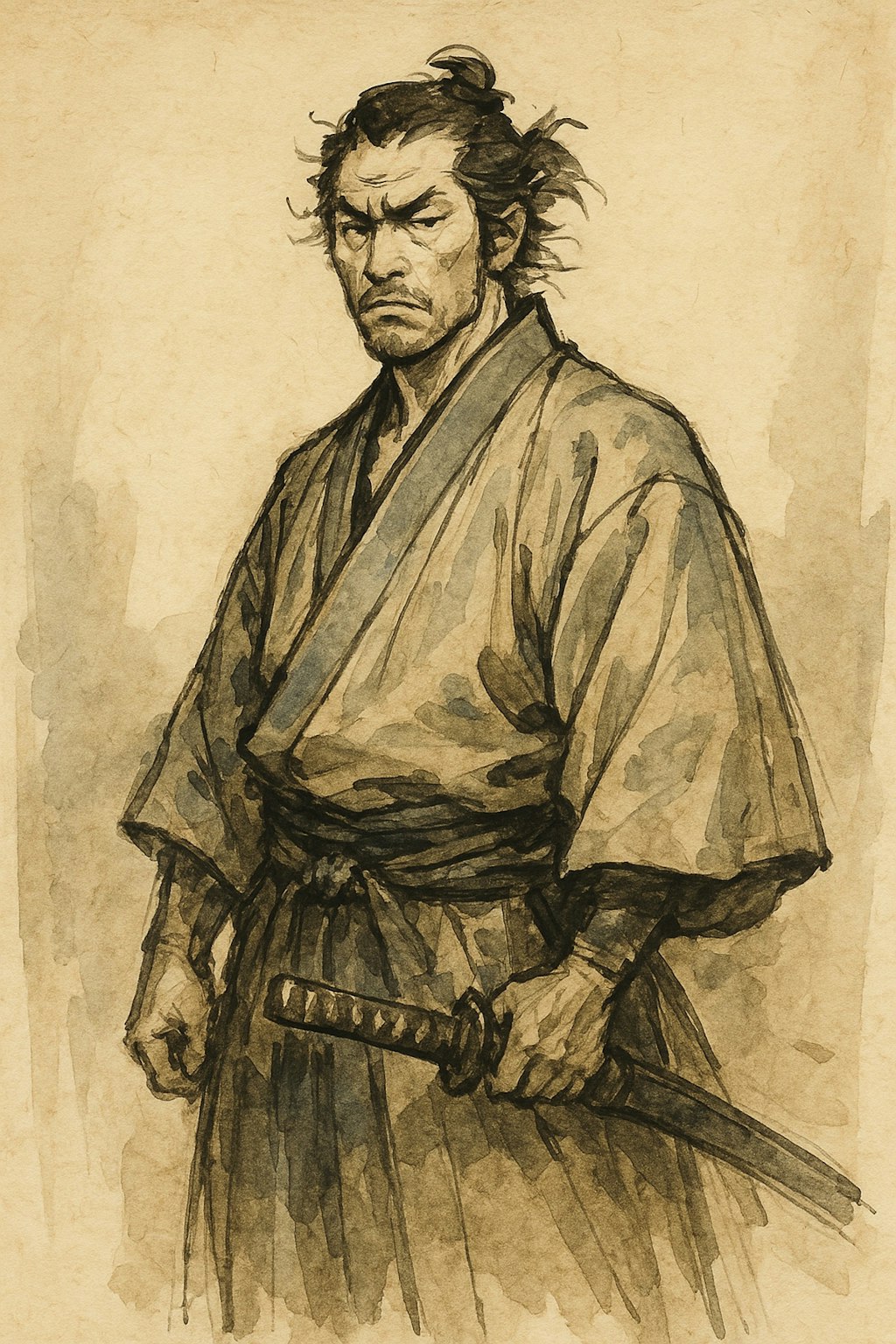

1、何も学習させず、共通プロジェクトファイルも使用していない状態で「俺の絵のスタイルで1枚描いて」の絵

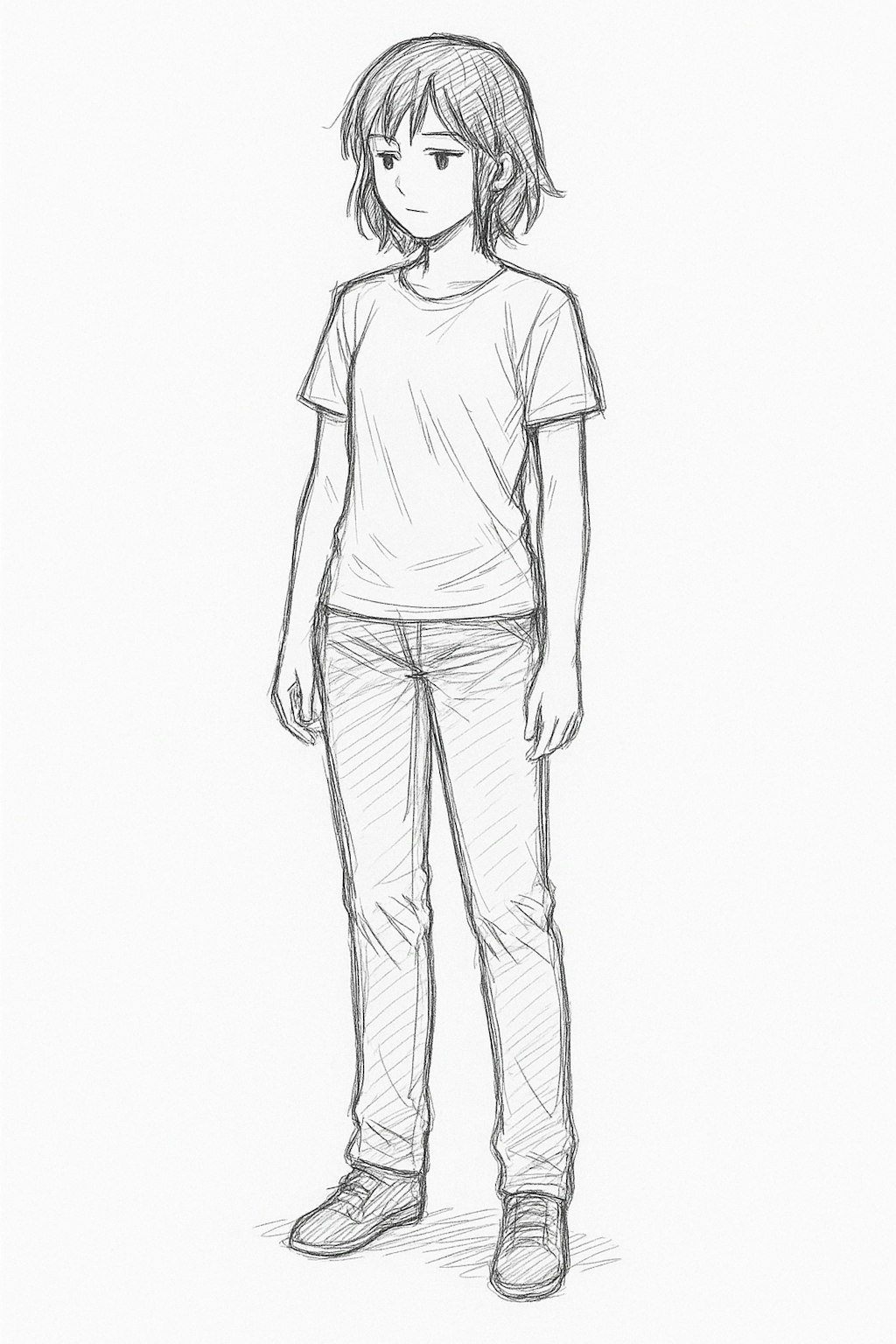

2,初期状態(新チャット+既に共通ファイルフォルダに20枚ある状態)

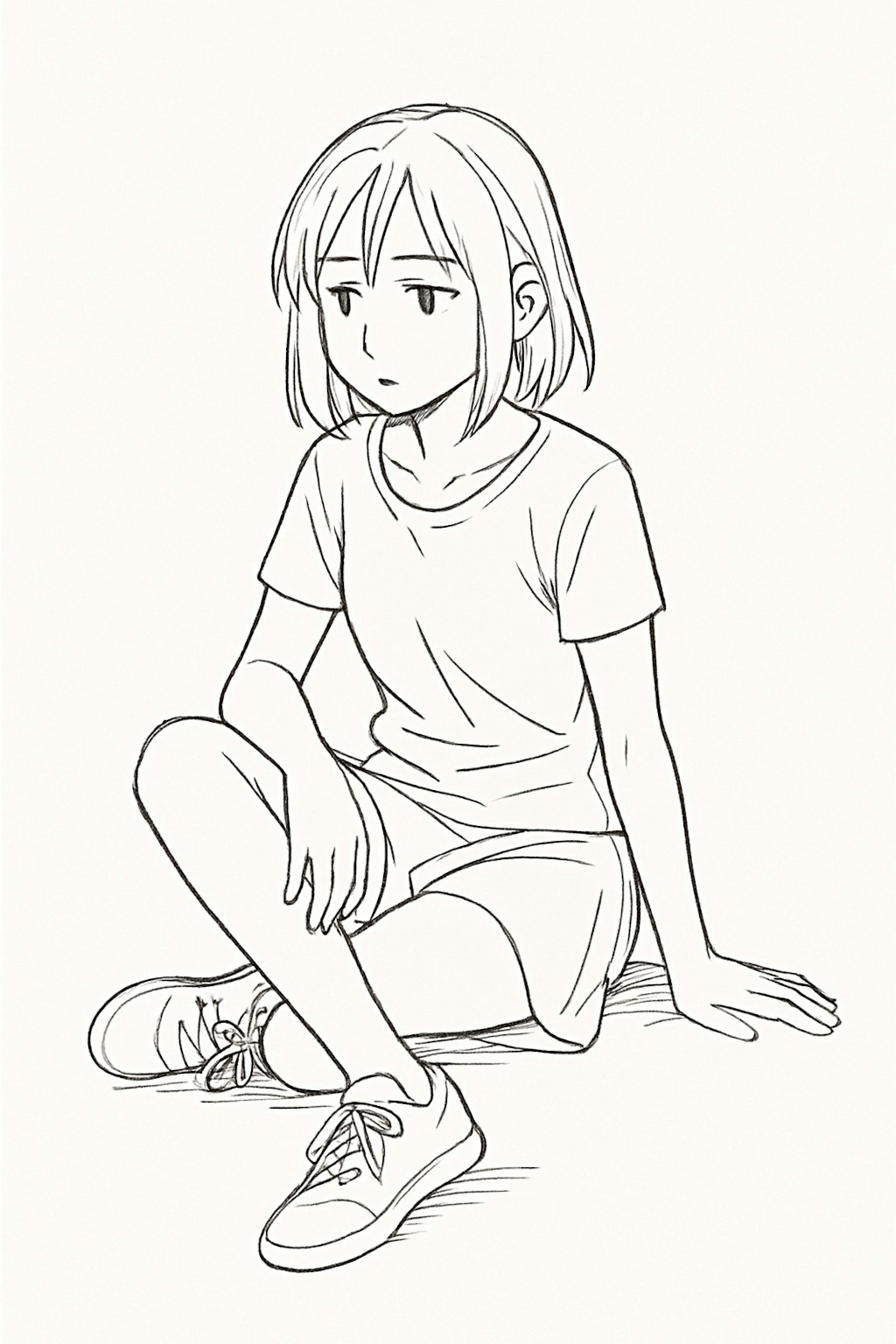

3,10枚(立ち絵のみ)学習させた後

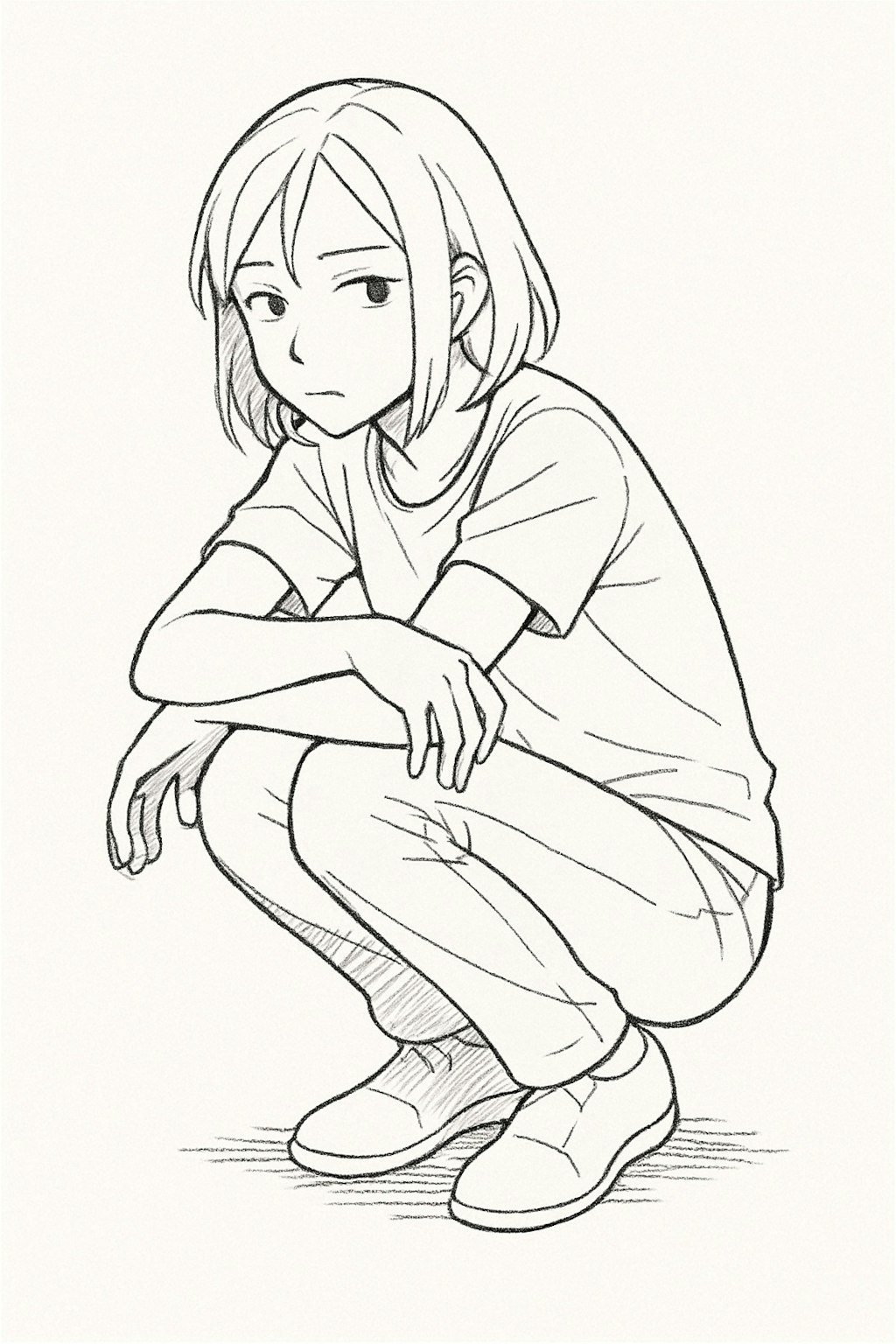

4,20枚(座り絵)学習させた後

5,30枚(しゃがみ絵)後

6,40枚目(別の立ち絵10枚)後

7,60枚目(複数、様々な年代性別のキャラを混ぜた20枚)

8,(複数、様々な年代性別のキャラを混ぜた20枚)をアップロードしたプロジェクトで、上記とは別の新しいチャットを立ち上げて学習させた後に、俺の絵としてGPTが描いてきた絵

🐟考察:

プロジェクト共通ファイルは大まかな方向づけしか影響を与えない

立ち絵、性別、モノクロ線画か、とかその程度。

DeepResearchの結果からも、プロジェクト共通ファイルを指定して利用することはできなくて、かすかな記憶としてだけ扱われるっぽい。

AssistantAPIがOpenAIの飯のタネなことから、ユーザーのファイルを直接GPTが参照できることを制限してると思われる。

アップロードデータ制限が80個(2~3時間ごと?)からもここが課金ポイントだと決めてる模様。(単体チャットの画風学習で70枚あたりで学習効果が強く出てくる。)

呪文

呪文を見るにはログイン・会員登録が必須です。

2件のコメント

コメントをするにはログインをする必要があります。

検証参考になります。

やはり基本は同一スレッド内でのみ学習保持してるっぽいですね。

欲しいタッチのイラストを読み込ませてから画像生成するほうが、好みのタッチのイラストをつくってくれそうですね。

タッチをGPTにかなり精密に解説させると学習強化される気がします

返信先: @